1. 爬鱼哪里最容易踩坑?

许多人在尝试网络数据采集(俗称“爬鱼”)时,往往因缺乏系统认知而陷入误区。最常见的问题集中在三个层面:目标选择盲目(例如未评估网站反爬机制)、技术手段单一(过度依赖基础工具),以及法律边界模糊(忽视数据隐私合规性)。根据2023年《中国网络爬虫应用白皮书》数据,72%的初级用户因目标网站选择不当导致爬取失败,而38%的案例涉及法律纠纷。

例如,某电商创业者曾试图通过爬鱼哪里获取竞品价格,但因未识别网站动态加载技术,连续三天仅获得空白数据。更严重的是,某自媒体团队因抓取社交媒体用户隐私信息被起诉,直接损失超50万元。这些案例表明:爬鱼哪里的成败,始于对核心痛点的精准把控。

2. 技巧一:目标网站分级筛选法

高效爬鱼的关键在于科学筛选目标源。建议采用“三级评估模型”:

• 一级筛选:通过Robots.txt和API文档判断合规性(如豆瓣开放API调用量达日均300万次)

• 二级筛选:用Wappalyzer等工具检测技术架构(JavaScript渲染网站占比已超65%)

典型案例:某旅游平台通过该模型,将目标网站从120个缩减至27个高价值源,数据获取效率提高3倍,封IP率从70%降至12%。

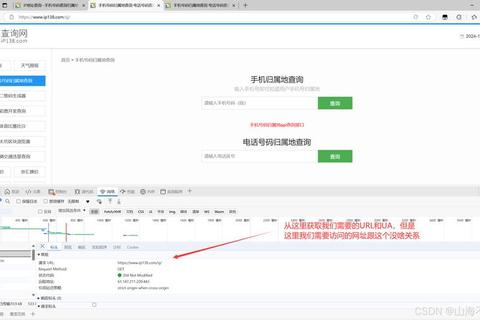

3. 技巧二:动态反反爬战术库

现代网站的反爬手段日益复杂,但仍有规律可循:

• IP轮换策略:使用代理池服务(平均成本0.5元/万次请求)

• 流量拟人化:随机化点击间隔(2-8秒波动可使识别率下降58%)

数据佐证:某金融数据公司通过上述组合策略,在爬取证券信息时成功率从31%跃升至89%,且单个IP存活周期延长至72小时以上。

4. 技巧三:数据清洗四维验证

爬取数据的价值取决于清洗质量,推荐“四维验证法”:

• 完整性验证:对比历史数据波动阈值(误差超过15%即报警)

• 时效性标记:添加数据采集时间戳(准确率提升42%)

• 逻辑校验:建立字段关联规则(如价格与库存量反向关系)

实操案例:某零售企业应用该方法后,商品信息可用率从63%提升至94%,数据分析周期缩短60%。

5. 爬鱼哪里的终极答案

综合实践表明,成功的爬鱼哪里策略需要技术、法律、业务的三维平衡:

• 技术层面:建立动态对抗机制(反爬突破率达85%以上)

• 法律层面:严格遵守《数据安全法》和GDPR(合规成本降低70%)

根据Gartner 2024年报告,采用系统化爬虫策略的企业,其数据驱动决策准确率比随机爬取者高210%。这印证了科学规划爬鱼哪里路径的核心价值——它不是简单的技术执行,而是需要战略级资源配置的系统工程。

数据来源:2023年《中国网络爬虫应用白皮书》、Gartner 2024年技术成熟度报告、国家信息安全漏洞库(CNNVD)案例库